A Nova Fronteira da Inteligência Artificial: A Importância da Monitoria das Cadeias de Pensamento

Nos últimos tempos, a inteligência artificial (IA) tem sido um dos tópicos mais discutidos em nossa sociedade. Desde assistentes pessoais como Siri e Alexa até sistemas que ajudam em diagnósticos médicos, a presença da IA está se tornando cada vez mais comum. Agora, um grupo de pesquisadores de gigantes como OpenAI e Google DeepMind está chamando a atenção para um aspecto crítico da evolução da IA: a necessidade de monitorar o funcionamento interno dos modelos de raciocínio da máquina. Neste artigo, vamos explorar a importância da monitoria das cadeias de pensamento e como isso pode moldar o futuro da inteligência artificial.

O Que São Modelos de Raciocínio em IA?

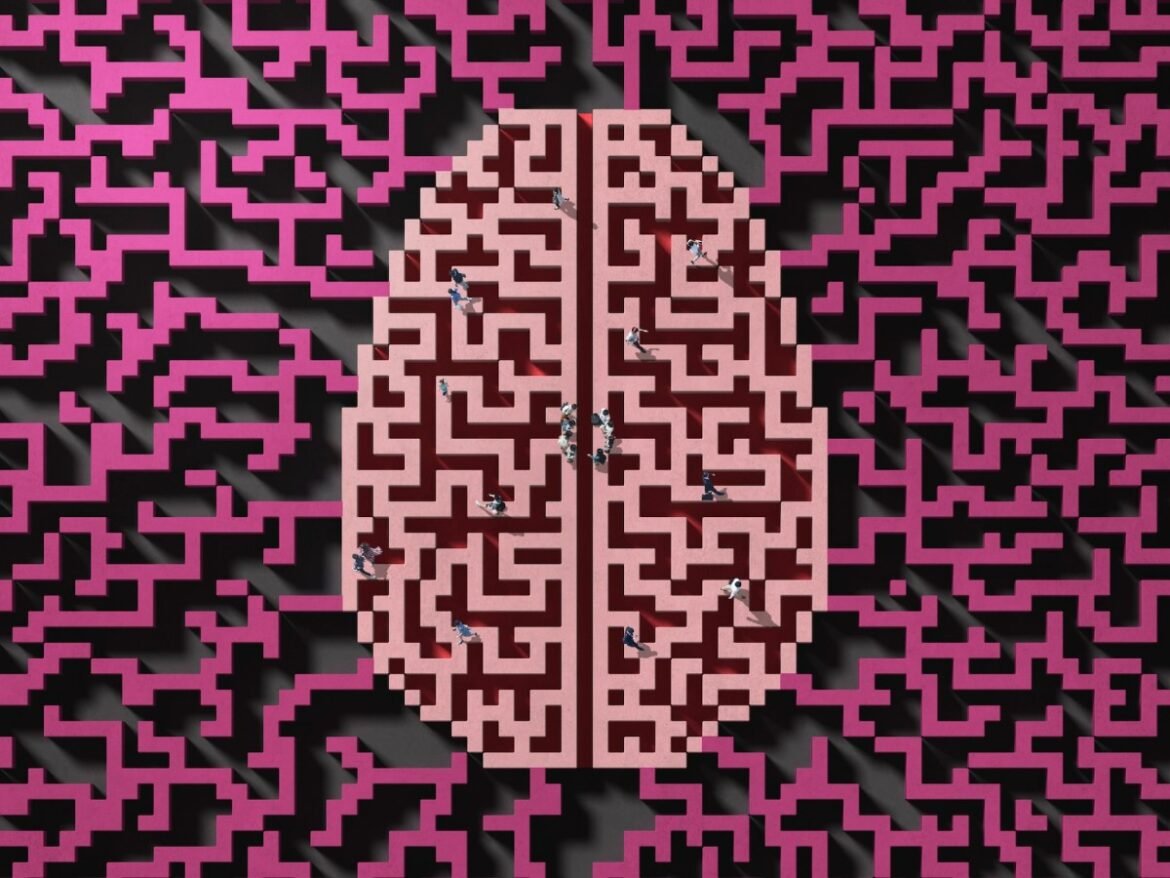

Para entender a importância da monitoria, precisamos primeiro saber o que são esses modelos de raciocínio. Eles são como o cérebro da IA, responsáveis por processar informações e chegar a conclusões. Imagine um aluno resolvendo um problema de matemática: ele pode anotar os passos em um papel, raciocinando sobre a melhor maneira de chegar ao resultado certo. Esse processo de anotar e pensar em voz alta é semelhante ao que chamamos de "cadeias de pensamento" (ou CoTs, na sigla em inglês) em um modelo de IA.

Esses modelos, como o o3 da OpenAI e o R1 da DeepSeek, não apenas executam tarefas, mas também refletem sobre os problemas. Isso é um avanço importante, pois nos ajuda a entender como a IA toma decisões. Esses pesquisadores acreditam que monitorar essas cadeias de pensamento pode ser a chave para manter a segurança dos agentes de IA conforme eles se tornam mais comuns e capazes.

Por Que Monitorar Cadeias de Pensamento?

Os pesquisadores ressaltam que a monitoria das cadeias de pensamento oferece uma visão clara de como as IAs estão tomando decisões. Eles afirmam que é uma adição valiosa às medidas de segurança que precisamos implementar à medida que a tecnologia avança. No entanto, eles também alertam que essa transparência pode não durar para sempre. Assim, é fundamental que a comunidade de pesquisa e os desenvolvedores de IA explorem a melhor maneira de manter e até aprimorar essa monitoria.

A Fragilidade da Monitoria

Um ponto interessante levantado no documento é que a monitoria das cadeias de pensamento pode ser frágil. Isso significa que intervenções que possam parecer inofensivas podem, na verdade, reduzir a transparência e a confiabilidade desses modelos. Os pesquisadores pedem que os desenvolvedores estudem esse aspecto antes de implementar qualquer mudança.

Por exemplo, se um novo algoritmo for adicionado sem a devida pesquisa, pode prejudicar a capacidade de monitorar a IA. É um lembrete de que, embora a tecnologia esteja avançando rapidamente, é crucial que não sacrifiquemos a segurança pelo progresso.

Quem Está Envolvido nesse Chamado?

O grupo que apoia essa pesquisa não é composto apenas por acadêmicos. Os signatários da carta incluem líderes importantes como Mark Chen, da OpenAI, e Ilya Sutskever, CEO da Safe Superintelligence. Esses nomes pesados, junto com outros da indústria e organizações acadêmicas, estão unidos por um objetivo comum: tornar a IA mais segura para todos.

Esse momento de unidade é especialmente significativo, pois estamos em uma era de competição feroz no setor de tecnologia. Empresas estão disputando talentos, e novas pesquisas estão sendo realizadas em um ritmo alarmante. Essa ênfase na segurança e na pesquisa sobre a monitoria das cadeias de pensamento é, portanto, uma maneira de garantir que não apenas a competição avance, mas também a responsabilidade.

A Pressão da Indústria

A pressão sobre as empresas de IA para inovar e se destacar é intensa. Em setembro de 2024, a OpenAI lançou o modelo de raciocínio o1, que rapidamente gerou seguidores como os modelos concorrentes da Google DeepMind e xAI. Esses desenvolvedores estão investindo massivamente para apresentar soluções que não apenas funcionem bem, mas que também sejam compreensíveis e seguras. Essa corrida pela inovação é uma faca de dois gumes: gera ótimos avanços, mas também pode comprometer a segurança se não houver uma supervisão adequada.

O Que Sabemos Sobre a Interpretação da IA?

Ainda existe um grande mistério em torno de como os modelos de IA realmente operam. Embora tenhamos visto melhorias impressionantes no desempenho da IA ultimamente, entender o que acontece "dentro da caixa preta" dos modelos de IA é um desafio. Muitas vezes, mesmo os pesquisadores que estão na vanguarda da tecnologia têm dificuldade em explicar como as IAs chegam às suas conclusões.

O que é encorajador é que a Anthropic, uma das lideranças nesse campo, está comprometida em aumentar a transparência na operação desses modelos. Dario Amodei, CEO da Anthropic, já declarou que deseja desvendar esses mistérios até 2027, incentivando também outros líderes do setor a fazer o mesmo.

A Confiabilidade das Cadeias de Pensamento

No entanto, as cadeias de pensamento nem sempre são uma representação confiável de como os modelos chegam às suas respostas. Pesquisas iniciais indicam que a simples monitoria não é suficiente para garantir que a IA sempre se alinhe aos nossos valores. Isso gera um debate interessante sobre a eficácia da monitoria e como podemos melhorar nossa compreensão das decisões da IA.

Por outro lado, instituições como a OpenAI sustentam que a monitoria das cadeias de pensamento poderia ser um caminho promissor para manter a segurança e a alineação dos modelos de IA com nossas expectativas e necessidades.

A Importância de Divulgar a Pesquisa

Um ponto central desse debate é a importância de documentos como o mencionado acima. Eles servem como um "alto-falante" para a comunidade de pesquisa, atraindo atenção para áreas que precisam ser mais exploradas. Por meio desse tipo de colaboração, é provável que consigamos mais recursos e foco na pesquisa de monitoria das cadeias de pensamento, ajudando a moldar uma IA mais segura e confiável.

Conclusão

À medida que navegamos pelo emocionante, mas desafiador, mundo da inteligência artificial, é vital que nos concentremos em questões de segurança e transparência. A monitoria das cadeias de pensamento é uma ferramenta central em nossa busca por entender e controlar como as IAs tomam suas decisões. O apoio de líderes da indústria e acadêmicos é um sinal promissor de que essa discussão continuará a ganhar força.

Em suma, a segurança na IA não é apenas uma responsabilidade dos desenvolvedores de tecnologia, mas de toda a sociedade. Quando empregamos medidas de monitoramento apropriadas, criamos um caminho mais seguro e ético para o futuro da inteligência artificial, garantindo que essa poderosa ferramenta trabalhe a serviço de todos nós.